Ich hab’s eilig! Ich will direkt zu:

AktuellerStatus von JDF und CIP4

Heidelberg News

Reporting und Analyse

Differenzierung und Marketing

Trends in der Medienaufbereitung

Prinect Business Manager (MIS CERM)

Trends in der IT-Infrastruktur

DeviceLink und Graubalance

Erzeugung von Druck-PDFs

Interaktives Design mit CS 5.5

Fazit

Am 28. und 29. Oktober 2011 fanden in der Print Media Academy in Heidelberg wieder einmal die jährlich von Usern des Vorstufen-Workflows Prinect organisierten Anwendertage statt. Ich besuche die Anwendertage seit einigen Jahren – zunächst, weil ich selbst dem System beruflich nahestand. Heute schätze ich die stets weiter perfektionierte Organisation, die sich insbesondere in immer präziser positionierten Anwendungs- und Zukunftsthematiken spiegelt. Die Heidelberger Druckmaschinen AG liefert den Rahmen dazu – zuletzt war die Stimmung dabei meist etwas gedeckt. Doch diesmal war ich sehr angetan von einem unterschwelligen „jetzt geht’s los“-Gefühl, das ich in der PMA zu verspüren meinte.

Traditionell ist der erste Tagungstag ein Freitag und richtet sich eher an das leitende Personal einer Druckerei mit technischem/druckvorstufigem Background. Der zweite Tag ist den Workshops und dem praktischen Austausch vorbehalten. Dass man dabei seitens der Heidelberger auf hochkarätiges Entwicklungs-, Marketing- und Entscheiderpersonal zugreifen kann, steigert den Wert der Veranstaltung beträchtlich. Und ich vermute, dass auch die Heidelberger sehr angetan sind, bei dieser Gelegenheit den Finger so dicht am Puls der Anwender haben zu können. Denn die nehmen dem Vortragenden gegebenenfalls auch mal das Heft aus der Hand, wenn ihnen etwas auf der Seele brennt.

JDF in der Druckindustrie – quo vadis?

Den Startschuß lieferte freitags Herr Mittelhaus mit einer Bestandsaufnahme zu JDF in der Praxis – offenkundig ein Kenner der aktuellen Lage von JDF/CIP4. Er sparte nicht mit offenen Worten zu Lücken und Pannen in der praktischen CIP4-Nutzbarkeit in produzierenden Unternehmen.

Ich habe aus seinem Vortrag verschiedene Erkenntnisse mitgenommen: CIP4 kämpft mit vielen klassischen Problematiken, die ein IT-getriebener Entwickleransatz mit sich bringt: JDF ist so komplex angelegt, dass bis heute noch daran gearbeitet wird, den vollen Funktionsumfang aufzubauen – während sich zeitgleich die Anforderungen an Workflows rapide ändern und erweitern.

Da man den aktuell gelebten Ansatz offenbar auch CIP4-intern nicht für zukunftsfähig hält, wird wohl sehr nachdrücklich an einer Vereinfachung und Verschlankung des Standards gearbeitet.

Aber – und das scheint mir das Wichtigste zu sein: JDF hat dafür gesorgt, dass es in der Druckbranche eine abteilungsübergreifende Informationsweitergabe gibt; und das entlang eines Standards. Das hat in unglaublichem Maß dazu beigetragen, Produktionsprozesse in Druckereien zu professionalisieren, Transparenz zu schaffen und Produktionssicherheit durch einheitliche Arbeitsvorbereitung zu ermöglichen. Interessanterweise stellte das auch niemand in Abrede; denn es ist täglich erlebtes Geschäft. Wer die Situation vor zehn Jahren kennt und mit der heutigen vergleicht wird feststellen, wie sehr die Branche von diesen Möglichkeiten profitiert hat:

Vor zehn Jahren war JDF irgendein weiterer Hype – heute steckt es in jedem Workflow, werden Auftragsinformationen transportiert, ist „Druck“ industriell und deutlich effizienter geworden.

Herr Mittelhaus forderte die Anwender dazu auf, sich aktiv an der Weiterentwicklung von JDF zu beteiligen. Und ich fordere ergänzend dazu auf zu sehen, was JDF für Druckereien bereits geleistet hat!

[ Seitenanfang ]

Heidelberg News

Bei den ersten Anwendertagen in Heidelberg trat der Lieferant des besprochenen Workflows noch sehr werberisch auf; Neuigkeiten wurden vollmundig angekündigt und große Mengen rosafarbener Wölkchen ausgestoßen; diese Zeiten sind glücklicherweise schon lange vorbei. Nicht zuletzt, weil die Anwender allzu forsche Ankündigungen bei den jeweils folgenden Anwendertreffen schonungslos thematisierten.

So stellte Axel Zöller heuer angenehm zurückhaltend dar, welche bedeutenden strukturellen Entscheidungen man offenbar bei Heidelberg getroffen hat, was die Zukunft von Prinect angeht.

Alleine über diesen Part sollte ich vermutlich einen Folgebeitrag schreiben; an dieser Stelle werde ich mich auf eine kurze Zusammenfassung beschränken:

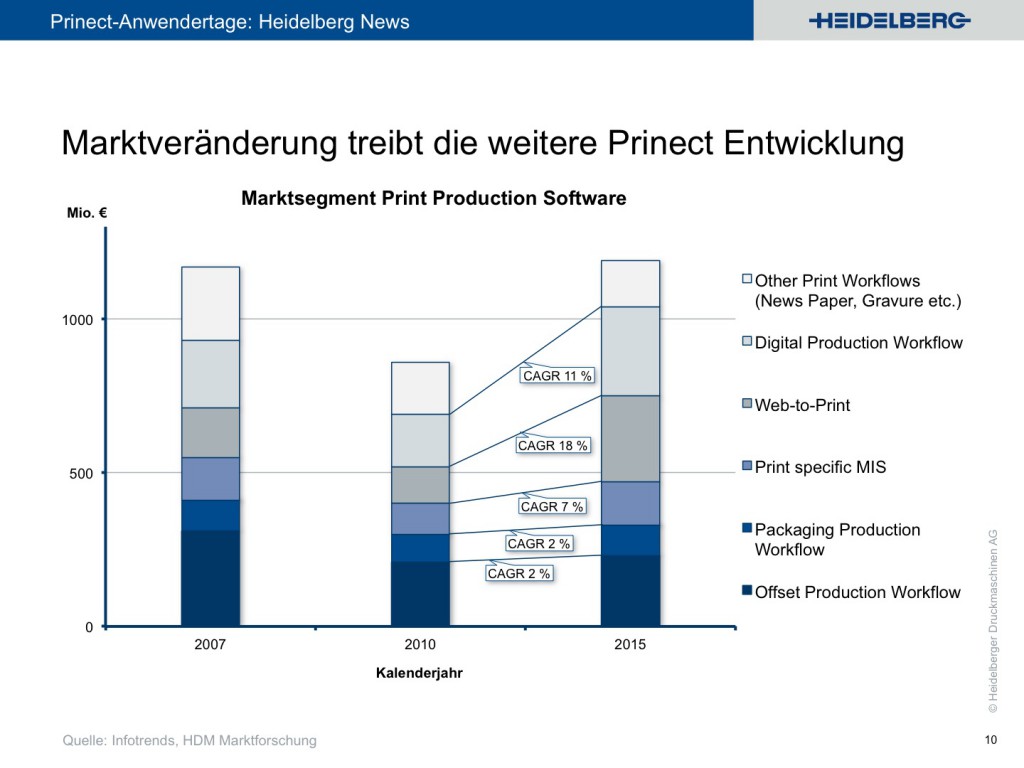

Heidelberg hat die Entwicklung der letzten Jahre analysiert und festgestellt, dass in den für sie relevanten Bereichen kaum mit einem nennenswerten Umsatzwachstum zu rechnen ist. Bei der Betrachtung der lukrativen Potenziale hat man eine ganze Reihe von digitalen Feldern identifiziert, in die man nun sehr nachhaltig drängt:

War Prinect vormals schon ein komplexer, abteilungsübergreifend angelegter Workflow, so wird Heidelberg nun noch kräftig einen draufpacken und – ergänzend zum produktiven „Kerngeschäft“ der Drucker – eine Reihe von Funktionalitäten integrieren die, wenn man das visionäre Gesamtpaket betrachtet, einen Zustand herstellt, in dem ein Druckunternehmer seine gesamte interne Abwicklung plus den Außenkontakt bis hin zur umfassenden Einbindung des Endkunden über ein Prinect-Gesamtpaket abbilden kann. Inklusive MIS, regelbasiertem Web-to-Print und Shop-System sowie direkt angebundenem Digitaldruck. Dabei spricht Heidelberg nicht von der Drupa 2012 als Zielkorridor, sondern – noch immer ambitioniert genug – davon, dass man in 2013 große Teile der Integration verkaufsfertig haben will.

Aus Sicht der Softwareentwicklung ist das ein monumentales und für Heidelberg wahrscheinlich existentielles Projekt. Ich halte es für den zukunftsfähigsten Weg – Heidelberg hat die richtigen Schlüsse aus der Entwicklung der Branche gezogen. Und hat stets den Drucker im Auge, der hohe Qualität bei verschiedenartigsten Produkten liefern möchte. Ich sage: WOW – und alles Gute für die Umsetzung!

[ Seitenanfang ]

Reporting und Analysemöglichkeiten

Bei der anschließenden Podiumsdiskussion stellten die Teilnehmer die Möglichkeiten und Probleme des „Analyze Point“ genannten Tools dar, das als Teil von Prinect genutzt werden kann, um auf Basis von Live-BDE-Daten einen Blick in den laufenden Betrieb zu nehmen und den Status zu bewerten.

Das Gespräch verlief etwas zäh und mit dem Gegenstand habe ich aktuell keine Berührung. Ein Thema, das sich am Rande der Diskussion ergab, interessierte mich deutlich mehr:

Offenbar sind die von Analyze Point gelieferten Informationen wunderbar geeignet, die Leistungen der Mitarbeiter direkt zu vergleichen und daraus Schlüsse bzw. Zielvorgaben abzuleiten.

Liebe Leute; an der Stelle kann ich nur auffordern, äußerst sensibel vorzugehen! Mir hat nicht gefallen, mit welcher Freude und Selbstverständlichkeit die Mehrheit der Unternehmer auf dem Podium diese technische Möglichkeit offenbar bewusst nutzt.

Die klare Aussage seitens Heidelberg dazu: rechtlich darf das in Deutschland nur in Abstimmung und mit Genehmigung des Betriebsrates in dieser Form genutzt werden!

[ Seitenanfang ]

Differenzierungsstrategien und Marketing

Stets mein besonderes Steckenpferd: wenn die anwesende Fraktion der „Schwermetaller“ mit feingeistigen Marketingthemen konfrontiert wird. Und hier trennt sich – meiner bescheidenen Meinung nach – die Spreu vom Weizen. Oder, um es noch deutlicher zu sagen, es entscheidet sich, wer auch in fünf bis zehn Jahren noch als Dienstleister auf diesem Markt bestehen wird.

Herr Hack von der estampado GmbH nahm diesmal die schwere Bürde auf sich, den anwesenden Technikliebhabern zu erklären, warum sie sich damit beschäftigen müssen, wie die Welt aus dem Blickwinkel eines Druckeinkäufers aussieht.

Es ist für mich einfach nur noch beklemmend zu sehen, dass viele Druckunternehmer weiterhin glauben, sich nicht damit beschäftigen zu müssen, welche Bedürfnisse ihre Kunden haben, wie diese Kunden Dienstleister finden und auswählen. Und selbst die recht plastischen Beispiele von Herrn Hack drangen offenbar nicht wirklich durch. Denn beim „Flurfunk“ im Anschluss nahm ich wenig „genau!“ aber dafür viel „brauchen wir nicht!“ wahr.

Die „Nichtbraucher“ werden in ein paar Jahren nicht mehr da sein. Falls sie nicht zufälligerweise bereits heute so komfortabel in einer Nische positioniert sind, dass sie selbst die Marktmechaniken nicht verstanden haben müssen, nach denen sie von ihren Kunden trotzdem gefunden werden …

Warum allerdings der Vortragende unter dem Firmennamen estampado GmbH auftritt – und dann unter der gleichnamigen Domain im Internet nicht zu finden ist, irritiert mich etwas. Wenn Sie Herrn Hack besser kennenlernen möchten, können Sie das unter http://www.druckereimarketing.de/ tun.

Anschließend ging es in die Workshops:

[ Seitenanfang ]

Trends in der Medienaufbereitung

Der Workshop wurde von Lucia Dauer, die bei Heidelberg für die Vermarktung der Web-to-Print Angebote verantwortlich zeichnet und Martin Klein, Geschäftsführer des Mediendienstleister CTRL-S in Stuttgart – und Mitorganisator der Anwendertage – geleitet.

Frau Dauer startete mit einer deutlichen Ansage: Heidelberg rechne nicht damit, dass das klassische Druckgeschäft nochmal ordentliche Wachstumsraten hinlegen würde – also hätte Heidelberg sich entschieden, künftig die wachsenden Bereiche der Branche einzufangen, die sich mit digitalen Workflows beschäftigen. Etwas, was ja bereits durch den Vortrag von Axel Zöller im Rahmen der Heidelberg News zuvor deutlich geworden ist.

Heidelberg wird seinen Workflow künftig verstärkt darauf ausrichten, medienneutrale Produktion zu ermöglichen – inklusive der Berücksichtigung von Bewegtbild. Ich bin gespannt, wie das aussehen wird. Und wer die bedienende Zielgruppe sein soll. Denn die Bedeutung einer intuitiv verwendbaren Benutzeroberfläche wird in der Softwarewelt stets sträflich unterschätzt.

Am Beispiel des von CTRL-S betreuten Veranstaltungskatalogs zur Buchmesse Frankfurt machte Herr Klein deutlich, wie sich die Arbeit seines Unternehmens für den Kunden Buchmesse in den letzten Jahren grundlegend verändert hat: war das Produkt früher eine reine 1-farbige Drucksache, hat sich der Prozess über die Jahre kontinuierlich verändert. Heute gibt es einen zentralen Datenbestand, auf den die „Lieferanten“ der Veranstaltungen per Web zugreifen, die Infos pflegen – und dann unterschiedlichste Ausgaben aus diesem Datenbestand erzeugt werden: personalisierte Rundgänge als PDF, drei verschiedene Printkataloge, Webanwendungen und – künftig – auch eine App für das Smartphone. Diese Verschiebung hat sich in den letzten fünf bis sechs Jahren ergeben. Farbe kam natürlich auch hinzu …

Damit hat sich die Arbeit für den Kunden von CTRL-S komplett verändert – und die Bindung des Kunden massiv erhöht. Unterhaltsam war, dass Herr Klein während des Workshops im Hintergrund die Skripte laufen ließ, mit denen die InDesign-Files aus dem Datenbestand erzeugt werden. Das Auditorium war hörbar beeindruckt – es war sehr still.

Natürlich bringt so ein Wechsel der Tätigkeiten der Mitarbeiter mit sich, dass intensiv mit dem Personal gearbeitet und persönliche Kompetenzen weiterentwickelt werden müssen. Ganze Tätigkeitsbereiche kommen neu hinzu; andere verändern sich nachhaltig und umfangreich. Leicht ist das sicher nicht – aber, wie Frau Merkel und Frau Dauer sagen, alternativlos.

[ Seitenanfang ]

Einführung in den Prinect Business Manager

Mit „Prinect Business Manager“ wird – auf Heidelbergdeutsch – verklausuliert das zu Jahresanfang von Heidelberg eingekaufte Management Information System CERM bezeichnet.

Mich hat sehr interessiert, wie das System aussieht und wie es funktioniert; hatte ich doch vor einigen Jahren eine große Anzahl von MIS-Systemen sondiert – und CERM ist mir dabei nicht untergekommen.

Ich muss vorausschicken, dass ich ein Vorstufenmann bin; die Wunder der Kalkulation kenne ich nur Rande als lästige Begleiterscheinung zur Abwicklung eines Druckauftrags. Da ich aber viele komplexe Systeme gesehen habe, befürchtete ich, dass Heidelberg sich ein solch umfassendes, träges, unbedienbares System eingekauft hat, um möglichst „alles“ abfischen zu können, was sich an Anforderung in diesem Umfeld tummeln kann. Aber auch hier kam es zu einer für mich neuen Erkenntnis:

Heidelberg konzentriert sich stark und bewusst auf die bogenorientierte Ausgabe – und verzichtet damit offenbar auch darauf, andere hochkomplexe Verfahren in die Kalkulation mit aufnehmen zu wollen. Eine weise Entscheidung, denn CERM schien mir sehr gut auf die Bedürfnisse eines Auftragssachbearbeiters in einem bogenorientierten Betrieb ausgerichtet zu sein – nicht mehr und nicht weniger.

Offenbar sieht Heidelberg gute Möglichkeiten, dieses MIS quasi „nahtlos“ im Prinect Gesamtpaket verschwinden zu lassen. Sichtbar war das noch nicht; der Look war sehr basic und erinnerte in Nichts an den klassischen Heidelberg-Cockpit-Look.

Was mich aber am meisten beeindruckte: das System reagierte äußerst flott und bot eine Reihe von gewichteten Empfehlungen an. Im Auditorium wurde zwar der etwas krude Look bemängelt; aber der war inhaltlich und funktional voll auf eine schnelle Kalkulation ausgerichtet. Und wenn das dann noch vollvernetzt mit den Standbögen einer Signa und den anderen Modulen funktioniert, hat Heidelberg hier technisch einen großen Wurf gelandet.

Fehlt nur noch eine schlanke, schicke Benutzeroberfläche … das gilt aber für alle Prinect-Module!

Am Rande der Demo wollte ein Drucker wissen, ob und wie er in dem System seine offenbar übliche 3%ige Überlieferung hinterlegen könne. Herr Bachthaler schien, wie ich, die Frage zunächst für ein Missverständnis zu halten. War es aber nicht; der Mann kalkuliert offenbar stets mit einer fixen Überlieferung. Wenn ich diesen Gedanken mit meinem Einkäufer-Background wirklich zulasse, hätte ich den Kerl direkt aus dem Fenster werfen müssen. Drucker, die nicht verstehen, dass ich eine bestimmte Menge eines Produkts bestelle weil ich genau die brauche – und die dann gezielt überliefern – werden blitzartig aus dem Dienstleisterbestand entfernt. Ich bin als Einkäufer bereit, aus technischen Gründen eine gewisse Schwankung hinzunehmen – positiv wie negativ. Aber wenn sich das zu einer Einnahmequelle erster Klasse entwickelt, platzt mir der Kragen: das ist Betrug an meinem Vertrauen!

Beruhigen konnte ich mich dann beim letzten Workshop des Tages:

[ Seitenanfang ]

Aktuelle Trends in der IT-Infrastruktur

Werner Kopczynski von der SWS Computersysteme AG beschloss meinen Tag mit einer angenehmen Bestätigung – dass ich schon vor Jahren richtigerweise die Entscheidung eingeleitet habe, neue Systeme in einer Vollvirtualisierung zu betreiben anstatt auf einzelne Server zu setzen. Das damals angeschaffte System entspricht vollständig dem, was SWS heute zur Umsetzung empfiehlt: Hochverfügbarkeit durch Dopplung und Verteilung von Systemen, ein gemeinsamer Storage für alle Systeme, Snapshots für schnelles Disaster-Recovery. Da meine Erfahrungen schon damals sehr positiv waren, konnte mich dieser Part also nicht so aus der Reserve locken.

Interessanter fand ich da schon zu hören, wieviel Energie durch „alte“ Server (4–5 Jahre) vergeudet wird: hier kann in etwas umfangreicheren Serverfarmen wie sie in Druckereien heute üblich sind, in wirklich beträchtlichem Umfang Strom gespart werden.

Und eine ebenfalls sehr wertvolle Information war, dass durch die Einführung einer Hochverfügbarkeitslösung für die Server der Produktionsumgebung ein Gespräch mit der Betriebsausfallsversicherung angeraten ist. Denn die reduzieren unter Umständen die Prämien derart massiv, dass in Kombination mit der Stromersparnis ein ROI der gesamten Anlage in weniger als einem Jahr möglich sei. Und das sollte nun wirklich jeder Unternehmer mal durchrechnen lassen, der mehr als drei Server herumstehen hat!

Im wahrsten Sinne des Wortes ein „wertvoller“ Workshop!

Und dann war der erste Tag vorbei und es näherte sich der zweite, reine Workshop-Tag:

[ Seitenanfang ]

DeviceLink-Profile und optimierte Graubalance-Optimierung

Im Zentrum dieses unerwartet spannenden Workshops standen – aus meiner Sicht – zwei Dinge: zum einen, dass Heidelberg verstanden hat (und Lösungen entwickelt), welche sicherstellen sollen, dass neben einer farblich sauberen – sprich: eine sich in den Toleranzen der PSO bewegende – Farbwiedergabe auch die Graubalance von großer Bedeutung ist. Und zum anderen, dass die Methoden, um das zu erreichen, so praxisnah bzw. so wenig produktionsinvasiv sein müssen wie irgend möglich.

Darüber hinaus wurde beleuchtet, warum das Zusammenspiel zwischen klassischen „Überdrucken“-Funktionen und Transparenzen technisch so schwierig anzugehen oder gar zu lösen ist.

Aber primär geht es hier um Farbe:

Insgesamt scheint der Trend zur Verwendung optischer Aufheller in Papieren anzuhalten oder sich gar verstärkt zu haben. Und das stellt die ganze Branche vor große Schwierigkeiten, die vielen Endkunden und Designern überhaupt nicht bewusst sind: diese Aufheller verhindern, dass bei der Farbmessung an der Druckmaschine Werte abgenommen werden, die mit dem Farbempfinden des Betrachters korrelieren.

Technisch passiert folgendes: die Aufheller sorgen für eine Verschiebung des Messergebnisses ins sprichwörtliche „Blaue“ hinein. Moderne Regelsysteme versuchen diese Verschiebung durch Verstärkung der Gelbanteile zu kompensieren. Da das Blau aber nicht wirklich vorhanden ist, sondern sich nur durch die chemische Beschaffenheit des Papiers ergibt, werden gelbliche Farbstiche in die Anpassungskurven hineingerechnet. Da es keinen messbaren Wert für die Aufheller gibt, wird jede Farbmessung zu einem Vabanquespiel. Eine höchst unbefriedigende Situation für alle Beteiligten. Ein stabiles, vorhersagbares Druckergebnis rückt damit in weite Ferne.

Heidelberg versucht, dieses Phänomen durch eine stärkere Gewichtung der Graubalance greif- und korrigierbar zu machen. Denn leider ist der Faktor „Graubalance“ in aktuellen Szenarien der ISO und der GraCol nur von untergeordneter Bedeutung – anders als beim System Brunner, das MAN Roland seit vielen Jahren als Bezugssystem der Wahl propagiert. Offenbar will die ISO in kommenden PSO-Versionen gleichfalls die Gewichtung der Graubalance erhöhen – eben, um das Problem der optischen Aufheller bei der Farbmessung besser in den Griff zu bekommen.

Nebenbei wurde erwähnt, in welchem prozentualen Umfang die Korrekturen hier eingreifen: typischerweise würden die Tonwerte um 1–2% verändert und es würden sich dabei DeltaE-Differenzen von bis zu 8 Einheiten ergeben. Ich finde sehr aufschlussreich, dass der gesamte Produktionsprozess heute offenbar so stabil ist, dass dieser geringe Veränderungsumfang solch massive Auswirkungen haben kann!

Zum Thema DeviceLink-Profile nehme ich mit, dass auch sie – natürlich – kein Allheilmittel für alle Sorgen im Drucksaal darstellen. Da es im Vortrag einen engen Zusammenhang mit dem Überdruckverhalten und Transparenzen gab, muss also stets bewusst entschieden werden, wann Farbkonvertierungen stattfinden und auf welche Art das geschieht. Und selbst dann ist nicht auszuschließen, dass bei einzelnen Produkten keine befriedigende Qualität erzielt werden kann – ob mit oder ohne den Einsatz von DeviceLink-Profilen.

Der Workshop war voll von interessanten Detailinformationen und wurde vom Heidelberg-Dreierteam Tatari / Häuser / Galeris und – begleitet von Martin Klein (CTRL-S) – sehr kurzweilig gehalten. Eigentlich hätte ich gerne eine Videoaufzeichnung dieses Workshops; denn auch meine Notizen konnten nur lückenhaft einfangen, was hier an wertvollen Infos durch den Raum schwirrte. Dabei war alles sehr praxisnah und hilfreich ausgelegt. Für mich war das ein absolutes Highlight der gesamten Anwendertage!

Überaus eindrucksvoll war auch der in den letzten Minuten präsentierte Bogen, auf dem als fünfte Farbe ein Pantone-Beige verdruckt wurde. Hier wurden die farbmetrisch passenden Anteile der plazierten Bilder gleichfalls in der Pantonefarbe gedruckt, während die dazugehörigen CMYK-Anteile zugunsten des Pantonetons reduziert wurden.

Um das Glück zu vollenden, konnten die Teilnehmer vergleichende Musterdruckbogen von Graubalance- und Pantone-Bildumsetzung mitnehmen. Ich freue mich darauf, diese Bögen im Kollegenkreis am Leuchttisch zu betrachten und zu diskutieren.

Es bleibt festzuhalten, dass dieser Workshop zeigt, wo wichtiges Zukunftspotential von handwerklich orientierten Druckereien liegt: in der einwandfreien Wiedergabe von kritischen Kundenaufträgen. Denn wer das nicht braucht, kann auch zu FlyerAlarm gehen …

Anschließend wechselte ich zu den PDFs:

[ Seitenanfang ]

Erzeugung von Druck-PDFs

Ehrlich gesagt hatte ich mich für einen anderen Vortrag angemeldet; denn wie Druck-PDFs erzeugt werden weiß ich. Beziehungsweise: da habe ich eine auf vielen Erfahrungen basierende Meinung zu. Da ich aber hörte, dass „mein“ eigentlicher Vortrag von einem „Selbstdarsteller erster Klasse“ gehalten wurde, habe ich mich dann doch entschieden, mein Wissen zu überprüfen. Und ich tat gut daran. Nicht, weil ich Neues über die Erzeugung von Druck-PDFs gelernt hätte, nein. Viel wichtiger: ich habe gelernt, an welchen Stellen die Programme der Creative Suite von Adobe so schlecht funktionieren, dass sie in sichtbarem Umfang Farbdaten so stark verändern, dass man es nicht ignorieren darf.

Geleitet wurde der Vortrag von Herrn Schneeberger; sein Frage-Antwort-Spiel muss man aushalten können; aber er wünscht sich verständlicherweise ein aktives Auditorium …

Ich gebe nur kurz zusammengefasst seine Denkanstöße weiter. Denn schlussendlich muss jeder für sich entscheiden, wie sehr das seinen Workflow betrifft. Und dann kann man sich eigene Mechanismen zur Überprüfung schaffen:

1. Ebenen in PDF/X-4

Hier gilt es festzuhalten, dass Adobe weiterhin nicht die vollständige Ebeneninformation aus InDesign in das PDF schreibt, die für die fehlerfreie Weiterverarbeitung notwendig wäre. Herr Schneeberger ruft darüber hinaus dazu auf, angelieferte x4-Dateien mit Ebenen sehr detailliert zu prüfen – denn man kann in Acrobat allerlei lustige Dinge für das technische Verhalten der Ebenen festlegen: Sichtbarkeit, Druckbarkeit …

2. JPEG2000

Herr Schneeberger schilderte umfassend, welche beträchtlichen Vorteile die Verwendung des in x4 zulässigen JPEG2000-Formats hätten. Da viele entgegennehmende Programme mit dem Format allerdings nichts anfangen können, würde ich von einer Nutzung in der Breite abraten. Und aufgrund meiner eigenen Erfahrungen dringend anraten, es auch intern nur nach gründlicher Prüfung bis hin zur Plattenbelichtung einzusetzen!

3. ZIP-Bildkomprimierung

Die kann offenbar nur 8 Bit-Bildmaterial komprimieren. Und wenn es in größerer Tiefe vorliegt: dann wird es in diesem Vorgang eben auf 8 Bit komprimiert. Das mag in den meisten Fällen nicht weiter stören; nun arbeite ich aber für einen Kunden, dessen Bildmaterial in 16 Bit vorliegt und vorliegen muss. Darüberhinaus gibt es mit der ZIP-Komprimierung eine unangenehme Problematik, die sich über den Berechnungsalgorithmus ergibt: die ZIP-Komprimierung ist schlichtweg unglaublich langsam!

4. InDesign und die Farbprofile

Wenn man sein Farbmanagement in der Creative Suite entlang der allgemein im Umlauf befindlichen Settings einrichtet, hat man ein kleines Problem, das sich offenbar aus einem Bug in der Ausgabefunktionalität von InDesign ergibt: obwohl alle Stationen entlang eines singulären ICC-Profiles laufen und nicht verändert werden dürften, kommt es offenbar zur Neuberechnung von Farbwerten bei der Ausgabe in ein PDF. Die Folge: durch „Rundungsfehler“ verändern sich Farbwerte, obwohl die betroffenen Objekte aufgrund der Settings überhaupt nicht tangiert werden dürften! Um das zu vermeiden bliebe aktuell nur die Möglichkeit, InDesign anzuweisen, Profile in Dokumenten zu „ignorieren“ – dann würde auch keine Berechnung auf diesen Objekten stattfinden. Ich werde in der nächsten Zeit versuchen, das nachzustellen und mir eine Meinung dazu zu bilden.

[NACHTRAG 29.11.2011] Bisher ist es mir nicht gelungen, das im Workshop beschriebene Phänomen nachzustellen. Um das zu tun, habe ich in Illustrator CS3 eine CMYK-Testform aufgebaut und mit ISO Coated v2 getaggt, die ich als AI und – in Photoshop CS3 gerastert nach ISO Coated v2 – in InDesign CS3 plaziert habe. Bei der PDF-Ausgabe mit den PDFx-ready-Settings 1.3 kann ich keinerlei Abweichung zu den Illustrator-Originaldaten feststellen. Sowohl CS3, CS4, CS5 und CS5.5 erzeugen bei mir von der Basisdatei identische PDF-Dateien. Abweichungen in den Farbwerten kann ich nicht feststellen.

5. Acrobat 10.1.1

Hier gibt es ein Problem bei der Transparenzreduktion, wenn Sonderfarben beteiligt sind. Werden die Transparenzen in Acrobat reduziert, wird die Sonderfarbe komplett nach CMYK aufgelöst. Ein ärgerlicher und gefährlicher Bug.

6. Verwendung komplexer Transparenz-Modi

Gänzlich dramatisch wird offenbar die Situation, wenn Objekte mit komplexen Transparenzmodi in einem Dokument verwendet werden. Am Beispiel von „Hartes Licht“ beschrieb Herr Schneeberger Farbveränderungen im Bereich von DeltaE 8, die vollkommen unerklärlich und damit unsteuerbar wären. Er empfiehlt, den Preflight entsprechend mit Warnungen beim Auftreten dieser komplexen Transparenzmodi auszustatten.

7. Transparenzreduktions-Einstellungen

Entgegen meiner altherhergebrachten – und bisher nie auffälligen – Settings rät Herr Schneeberger dazu, keinen 100%igen Pixel-Vektorabgleich zu verwenden. Das würde zu hohen Rechenzeiten und schlechteren Ergebnissen führen; denn es käme teilweise zu Versätzen zwischen Pixel- und Vektorobjekten, die bei Einstellungen wie 75% nicht aufträten. Das ganze natürlich nur bei „belichtungsfertigen“ Pixeleinstellungen; also 2.400 dpi oder der tatsächlichen Belichterauflösung.

8. XPress und die Transparenzen

Die Transparenzen, die über die entsprechenden Gestaltungsfunktionen von XPress ins Dokument kommen, seien unkritisch – die würden mittlerweile sauber und nativ im PDF landen. Anders sähe das mit plazierten Objekten aus: die könne XPress zwar mittlerweile verarbeiten – aber es würde sie immer (!) verflachen und deren Transparenzen somit nicht in das PDF durchreichen. Das ist natürlich höchst unangenehm und qualitätsmindernd.

9. PDF aus Office-Programmen

Mir war bisher nicht bekannt, dass XPSP3, Vista und Win7 offenbar in der Lage sind, von Haus aus PDF-Dateien zu sichern. Dieses Format kann ganz einfach beim Abspeichern der Dateien ausgewählt werden. Und im Fall von Word würde das sogar so weit gehen, dass randabfallende Dokumente inklusive der unsichtbaren, außerhalb der Nutzfläche liegenden Anteile, ausgegeben würden. Dabei muss es sich allerdings um technische Objekte handeln; Bilder werden am Seitenrand abgeschnitten.

Und zu guter Letzt schaute ich mir die „Digital Publishing Suite“-Funktionen von Indesign an:

[ Seitenanfang ]

Adobe CS5.5 – InDesign und Photoshop

Herr Stefan Lamb zeigte die drei neuen, interaktiven Ausgabeformate von InDesign CS5.5:

Herr Lamb lieferte dem Auditorium eine aufschlussreiche kurze Einführung. Dabei stellte er übersichtlich und praxisnah dar, wie die Interaktivierung eines InDesign-Dokuments abläuft und wie man daraus eines der drei neuen Exportformate SWF – ePub – Folio erzeugt.

Im Anschluss lieferte er noch einige Demonstrationen von verschiedenen neuen oder überarbeiteten Photoshop-Funktionen der CS 5.5. Herausragend für den Gelegenheitsanwender von Photoshop wie mich waren dabei folgende Funktionen:

Das Freistellen komplexer Objekte über die Funktion „Kanten verbessern“, die auf nahezu beliebige Auswahlen anwendbar ist.

Wer schnell ein Bild im derzeit beliebten Tilt/Shift-Look erstellen möchte, kommt mit der „Tiefenschärfe abmildern“-Funktion zum Ziel. Hier wirkt die Funktion auf einen Verlauf im Alphakanal – der natürlich zuvor angelegt worden sein muss.

Und schließlich gibt es allerlei Stellen in Photoshop, bei der „inhaltsbezogen“ gelöscht oder skaliert werden kann – das gibt es zwar auch schon länger; aber man sollte diese Funktionen bewusst in sein „Bearbeitungsportfolio“ aufnehmen – man kann viel Zeit sparen; auch, wenn das Ergebnis der eigentlichen Photoshop-Funktion eventuell noch nicht überzeugend ist. Die Nachbearbeitung des Outputs dieser Funktion mag nämlich deutlich flotter von der Hand gehen als eine vollständige manuelle Retusche.

[ Seitenanfang ]

Fazit

Auch die Anwendertage 2011 sind wieder jede einzelne Minute wert gewesen! Zu sehen, wie die Heidelberger offenbar begonnen haben, sich neu zu erfinden, beeindruckte mich sehr. Ich wünsche ihnen viel Erfolg für den eingeschlagenen Weg. Denn ich halte ihn für den richtigen Pfad in eine lukrative Zukunft; wenn dabei stets die Benutzer der Systeme im Auge behalten werden und ihnen zugehört wird.

Aber zurück zu den Anwendertagen selbst:

Die geballte Kraft einer solch umfangreichen, anwenderorientierten und hochkarätig besetzten Tagung – die immer mehr auf „Frontalunterricht“ verzichtet und verstärkt auf Interaktion setzt – ist ausgesprochen wertvoll.

Ich danke dem Organisationsteam und den „Heidelbergern“ herzlich dafür, dass sie wieder die Mühe auf sich genommen haben, diese Veranstaltung zu organisieren und freue mich auf nächstes Jahr!